こんにちは、白鳥です。

こんにちは、白鳥です。

今回はロボットを直感的かつ自由に動作させる方法の実験事例についてご紹介します。

私たちの開発しているugoというロボットは、移動するためのカート、ボタンを押す、ペットボトルなどを持つなどの軽作業を行うボディー(ボディーにはアーム、ハンドが付いています。)、ボディーを上下させるためのリフターで構成されています。 現状、ugoはカートはPCからキーボードで指示する、アームはポータルサイトで作成したモーションを再生するなどの方法で操作が可能です。

今回は、カート、アーム、ハンド、リフターを、1つの入力デバイスでリアルタイム&自由に動作させる方法について複数の方式で実験を行いました。

直感的な操作を実現する2つの手法

(1) VRヘッドセット+VRコントローラ型

VRヘッドセット(PICO4)を使い腕、ハンド、カート、リフターを動かします。

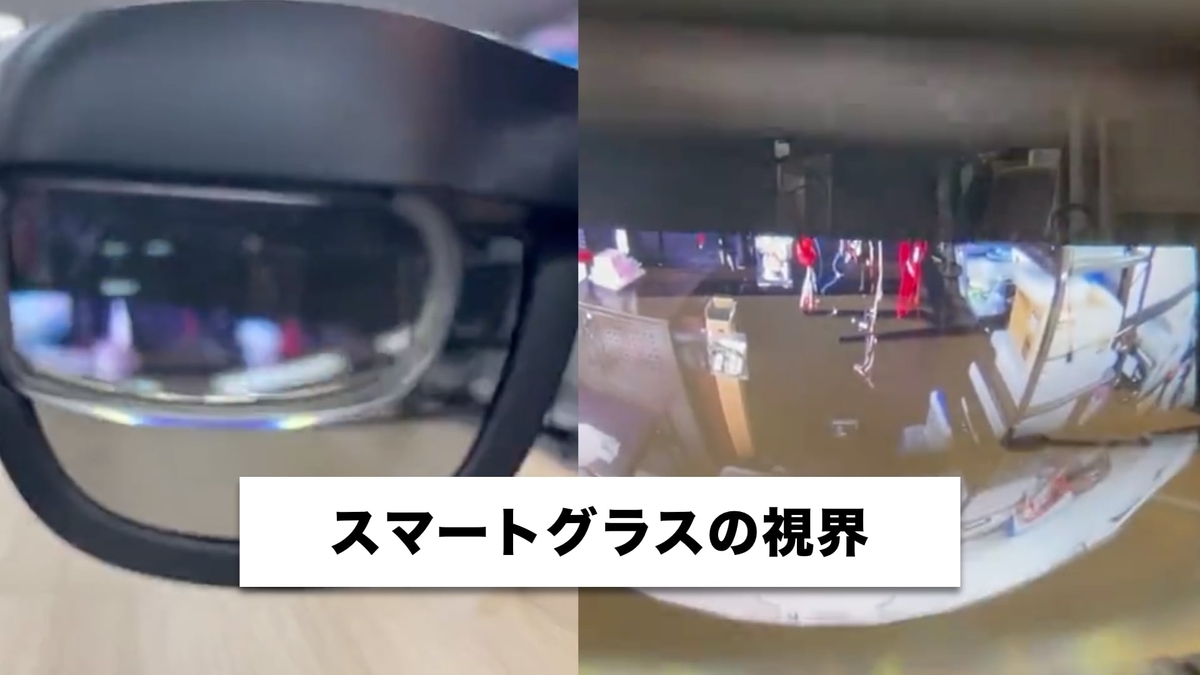

(2) スマートグラス+モーションキャプチャ型

スマートグラス(NrealAir)でカメラ映像見ながら、iOSのARKitのモーションキャプチャを用いて操作者の腕の姿勢を推定しugoのアームを連動させて操作します。

実験結果

- VRヘッドセット(PICO4)を使用した操作の動画です。

VRヘッドセットを使用してペットボトルをつかむ操作をした動画です。

- スマートグラス(NrealAir)+ARKitを連動させた操作の動画です。

動画では手前でiPhoneで操作者を撮影してARkitでリアルタイムに姿勢推定してugoの腕と連携させています。

スマートグラスはugoのカメラ映像を映しています。(実物の方がはっきり見えています。)

VRゴーグルで操作者の移動と同期した動画です。操作者とロボットがお互いを見ながら直進しています。

VRゴーグルで操作者の移動と同期した動画です。操作者とロボットがお互いを見ながら直進しています。

考察

- PCなどを使わなくてもVRゴーグルだけでugoを自在に操作することができました。

- スマートグラスのNrealAirが軽い、かつコントローラーを持たないため、操作者の負担が少ないと感じました。

操作者への負担が軽いと、長時間の操縦が可能となるかもしれません。

参考:NrealAir 76g、PICO4 588g (ストラップ、バッテリー込み)、コントローラー133g - NrealAirは3Dofのため、上を向けばugoの天井の映像が見え、下を向けば足下の映像が見えます。

今回は手を握る動作までは連携していませんが、連携させれば物を掴むくらいは可能と考えております。

今後の課題

- 1の場合はVRゴーグルで操作するためugoを縦横無尽に動かすことが可能ですが、カメラ映像だけのため距離感が掴めず、物を掴むなどの動作は少し難しいと感じました。

そのため、デプスカメラなどの距離を測定するセンサーの補助があった方が良いと考えます。 - 2の場合は姿勢推定しているためか、動かしている腕に釣られて動かしていない腕の方も少し動いてしまうことがありました。

そのため精密な動作は難しいかもしれません。 - 2の場合も1の場合と同様に操作はカメラ映像のみとなるため、物を掴む場合は距離を測定するセンサーの補助が必要と考えています。

また、移動やリフターを操作するには、別途コントローラーが必要になります。

今回の記事でご紹介した2種類の操作方法は、まだまだ実験的なアイデアで、実用性という観点ではクリアしなければならない課題も多くありますが、誰でも簡単に使えるロボットを目指して、様々なUI/UXを実験しブラッシュアップしていきます。

ugoでは、一緒にロボットを社会実装していく仲間を絶賛募集中です。

詳しくはこちら👇まで。